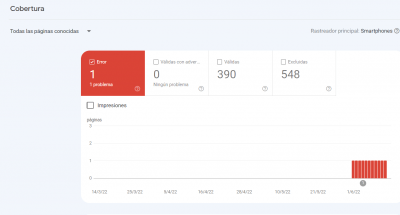

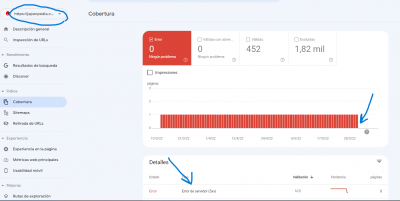

Hola. Comentar que en un hilo ya cerrado, expuse un error 500 que me marca Serach console. Me dijeron que probara con modificar el Sistema CRON (ya lo hice). También he cambiado el plugin de cache y revisado la web de Japonpedia (se supone que es en esta web donde ser consume muchos recursos del servidor), pero el problema de conexión con el servidor sigue mostrándose en Google Search console.

Me he fijado en que en muchas ocasiones, cuando entro en Guiavi, el navegador al principio muestra una pantalla de dice "error de conexión". Pasan 3 o 4 segundos y después aparece la web.

¿Pueden estar relacionados este error de conexión de Guiavi con el error que se muestra en search console con el servidor? ¿Qué puedo hacer para resolverlo?

Gracias.

Contenido solo visible a usuarios registrados

Hola Jesus,

Al ingresar en tu sitio web no veo ningún problema de carga, tampoco logro ver algún error relacionado en stephan con el sitio web que nos compartes. Si en posible envíanos algunas captura sobre este error que se muestra para verificar con mayor detalle, igualmente si deseas ver todo este correcto puedes enviar un ticket a soporte para que revisen todo esté correcto en tu cuenta de hosting.

Un Saludo

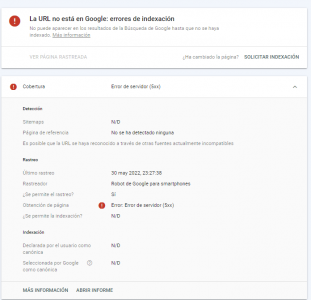

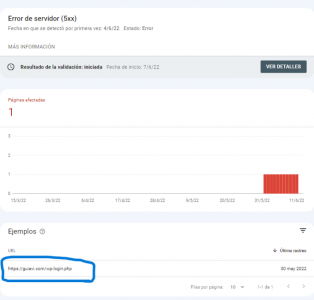

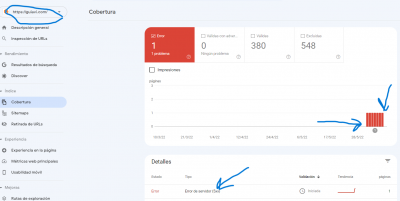

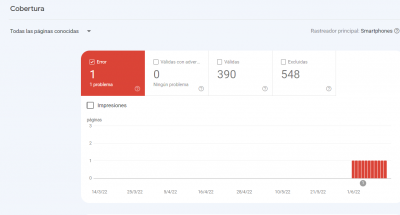

@karen. Le paso algunas capturas de pantalla.

Me comentan esto en Webempresa:

Por lo que veo en una de las capturas de pantalla, uno de los ejemplos que generan error 5xx es en el acceso al wp-login.php. Lo habitual es que esa url esté excluida, ya que es la de acceso a la administración de la web. Si tienes dudas sobre cómo configurar el fichero robots.txt, puedes consultar con mis compañeros de foro.

Mi robots.txt en Guiavi es el siguiente:

user-agent: *

disallow: /wp-admin/

allow: /wp-admin/admin-ajax.php

sitemap: https://guiavi.com/sitemap_index.xml

Este es el archivo robots-txt que tengo implantado en Japonpedia, donde se producen los picos de recurso en el servidor:

User-agent: *

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-admin/

Sitemap: https://japonpedia.com//sitemap_index.xml

Me han comentado que podría implantar en crawl delay. He estado buscando como hacerlo para evitar estos picos, pero no lo tengo claro. ¿tal vez así?:

User-agent: *

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-admin/

Sitemap: https://japonpedia.com//sitemap_index.xml

User-agent: *

Crawl-delay: 5

Supongo que tendré que implantarlo en sólo en Japonpedia, que es donde se dan los picos... Sin embargo el problema ahora me lo marca en Guiavi.

En Guiavi Google search console me pone como error esta url:

https://guiavi.com/wp-login.php

Lo raro es que el mismo error lo tenía en Japonpedia, ha pasado a Guiavi y ha dejado de aparecer en Japonpedia. No se si tendrá algo que ver o casualidad, pero el mes pasado ha superado Guiavi a Japonpedia en número de entradas y volumen de contenido.

Muchas gracias Karen.

Hola Jesus.

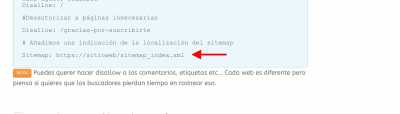

.- Edita el archivo robots.txt y añade el código que tienes al final de esta entrada:

-> https://www.webempresa.com/blog/robots-txt-en-wordpress-que-problema-tienes-googlebot.html

Del código tienes que modificar la ultima linea del sitemap por la URL de tu sitemap:

La url de tu sitemap seria la siguiente:

Contenido solo visible a usuarios registrados

Una vez lo tengas pulsas en el boton de Validar corrección y espera que google lo valida, pueden pasar semanas hasta que google mande el correo con el resultado de la validación.

Un saludo

Perdona, no entiendo como tendría que quedar, ya que en esta entrada veo varios roboxt diferentes.

La línea que comentas ya la tengo creada: https://guiavi.com/sitemap_index.xml

Ahora mismo lo tengo configurado así:

user-agent: *

disallow: /wp-admin/

allow: /wp-admin/admin-ajax.php

sitemap: https://guiavi.com/sitemap_index.xml

En Japonpedia así:

User-agent: *

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-admin/

Sitemap: https://japonpedia.com//sitemap_index.xml

Un saludo Pepe.

Hola Jesus.

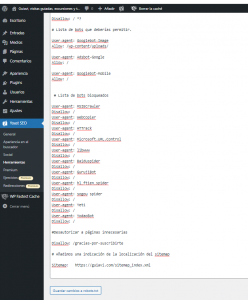

Tienes que añadir solo el código del ultimo bloque esta todo el Robots, lo comparto entero, solo copia y pega en el archivo robots.txt ( Elimina primero el que tienes ahora )

# Bloquear o permitir acceso a contenido adjunto. (Si la instalación está en /public_html).

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Disallow: /wp-includes/

Disallow: /wp-admin/

#Impedir el acceso a los diferentes feed que genere la página

Allow: /feed/$

Disallow: /feed

Disallow: /comments/feed

Disallow: /*/feed/$

Disallow: /*/feed/rss/$

Disallow: /*/trackback/$

Disallow: /*/*/feed/$

Disallow: /*/*/feed/rss/$

Disallow: /*/*/trackback/$

Disallow: /*/*/*/feed/$

Disallow: /*/*/*/feed/rss/$

# Impedir URLs terminadas en /trackback/ que sirven como Trackback URL.

Disallow: /*/*/*/trackback/$

# Evita bloqueos de CSS y JS.

Allow: /*.js$

Allow: /*.css$

#Bloquear todos los pdfs

Disallow: /*.pdf$

#Bloquear parámetros

Disallow: / *?

# Lista de bots que deberías permitir.

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: Adsbot-Google

Allow: /

User-agent: Googlebot-Mobile

Allow: /

# Lista de bots bloqueados

User-agent: MSIECrawler

Disallow: /

User-agent: WebCopier

Disallow: /

User-agent: HTTrack

Disallow: /

User-agent: Microsoft.URL.Control

Disallow: /

User-agent: libwww

Disallow: /

User-agent: Baiduspider

Disallow: /

User-agent: GurujiBot

Disallow: /

User-agent: hl_ftien_spider

Disallow: /

User-agent: sogou spider

Disallow: /

User-agent: Yeti

Disallow: /

User-agent: YodaoBot

Disallow: /

#Desautorizar a páginas innecesarias

Disallow: /gracias-por-suscribirte

# Añadimos una indicación de la localización del sitemap

Sitemap: https://guiavi.com/sitemap_index.xml

Un saludo

@pepesoler. Perdona, pero no entiendo muy bien como. Te refieres de esta forma? Sería correcto también para Japonpedia?

User-agent: MSIECrawler Disallow: / User-agent: WebCopier Disallow: / User-agent: HTTrack Disallow: / User-agent: Microsoft.URL.Control Disallow: / User-agent: libwww Disallow: / User-agent: Baiduspider Disallow: / User-agent: GurujiBot Disallow: / User-agent: hl_ftien_spider Disallow: / User-agent: sogou spider Disallow: / User-agent: Yeti Disallow: / User-agent: YodaoBot Disallow: /

sitemap: https://guiavi.com/sitemap_index.xml

Un saludo.

Hola Jesus.

Te refieres de esta forma?

Sí pero copia todo desde el principio al final, el código que compartí en la anterior consulta todo entero.

Sería correcto también para Japonpedia?

Lo mismo, lo unico que cambia es la URL del Sitemap:

sitemap: Japonpedia.com/sitemap_index.xml

Un saludo

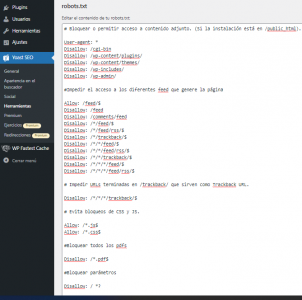

Gracias. Te confirmo abajo lo que he copiado en Yoast Seo/herramientas/editor de archivos/

Donde pone #Desautorizar a páginas innecesarias

Disallow: /gracias-por-suscribirte

Creo que no tengo una url así. ¿Lo dejo tal cual?

Este Robotx me vendría también bien para visitasguiadasvaticano.com y Japonpedia? ¿No tengo que adaptar nada?

Supongo que ahora tengo que poner Sitemap: https://guiavi.com/sitemap_index.xml en Sarch Console Sistemap para que indexe el nuevo. ¿Cierto?

Muchas gracias Pepe. Perdona, estoy muy pegao con esto de los códigos. Gracias.

Esto es lo que he copiado:

# Bloquear o permitir acceso a contenido adjunto. (Si la instalación está en /public_html).

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Disallow: /wp-includes/

Disallow: /wp-admin/

#Impedir el acceso a los diferentes feed que genere la página

Allow: /feed/$

Disallow: /feed

Disallow: /comments/feed

Disallow: /*/feed/$

Disallow: /*/feed/rss/$

Disallow: /*/trackback/$

Disallow: /*/*/feed/$

Disallow: /*/*/feed/rss/$

Disallow: /*/*/trackback/$

Disallow: /*/*/*/feed/$

Disallow: /*/*/*/feed/rss/$

# Impedir URLs terminadas en /trackback/ que sirven como Trackback URL.

Disallow: /*/*/*/trackback/$

# Evita bloqueos de CSS y JS.

Allow: /*.js$

Allow: /*.css$

#Bloquear todos los pdfs

Disallow: /*.pdf$

#Bloquear parámetros

Disallow: / *?

# Lista de bots que deberías permitir.

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: Adsbot-Google

Allow: /

User-agent: Googlebot-Mobile

Allow: /

# Lista de bots bloqueados

User-agent: MSIECrawler

Disallow: /

User-agent: WebCopier

Disallow: /

User-agent: HTTrack

Disallow: /

User-agent: Microsoft.URL.Control

Disallow: /

User-agent: libwww

Disallow: /

User-agent: Baiduspider

Disallow: /

User-agent: GurujiBot

Disallow: /

User-agent: hl_ftien_spider

Disallow: /

User-agent: sogou spider

Disallow: /

User-agent: Yeti

Disallow: /

User-agent: YodaoBot

Disallow: /

#Desautorizar a páginas innecesarias

Disallow: /gracias-por-suscribirte

# Añadimos una indicación de la localización del sitemap

Sitemap: https://guiavi.com/sitemap_index.xml

Hola Jesus.

Creo que no tengo una url así. ¿Lo dejo tal cual?

Si, o si no tienes una pagina de agradecimiento simplemente eliminas esa URL peor no importa tampoco si lo dejas tal cual.

Este Robotx me vendría también bien para visitasguiadasvaticano.com y Japonpedia? ¿No tengo que adaptar nada?

Solo modificar la URL del Sitemap, es un código estándar que sirve para cualquier web.

Supongo que ahora tengo que poner Sitemap: https://guiavi.com/sitemap_index.xml en Sarch Console Sistemap para que indexe el nuevo. ¿Cierto?

No hace falta, del sitemap no modificamos nada lo unico que realizaste en el archivo robots.txt es denegar accesos por ejemplo al wp-admin/login y bloquear algunos robots.

Lo que hicimos del sitemap es añadir la URL simplemente para que cuando el robot visite la web facilitarle la URL hacia el sitemap pero esta no cambia sigue siendo la misma que tenias anteriormente y que subiste a la consola de Google.

Solo tienes que validar la corrección en la consola de google y esperar a la validación de google.

Un saludo

@pepesoler muchas gracias por todo.

Ya lo he incluido en las 3 webs. También he configurado el Cron. Entre las dos cosas a ver si se elimina el error que me marga Google Search Console.

Un saludo Pepe y que pases un buen día.

Jesús

Hola jesus.

Nada Gracias a ti.

Dejo el hilo abierto por si necesitas retomarlo.

Un saludo