Hola,

Nos estamos volviendo locos con este tema.

A finales de marzo nos metimos en el search console y nos dimos cuenta de que teníamos un problema de cobertura en la web.

Detectamos que teníamos un problema con el servidor que webempresa no ayudo a corregir, con lo que el 100% de los intentos de rastreo de la web tuvo algún problema. También nos hemos dado cuenta de que el archivo robots.txt nos está dando problemas.

Actualmente este es el que tenemos:

user-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Al ir al probador de robots.txt de la consola de Google me dice que la última versión vista es del 31 de marzo donde daba error.

Cuando vamos a la cobertura vemos que ese día que dio el error del servidor 10 páginas que teníamos validadas fueron excluidas. Y dejamos

de aparecer en Google...

Si vamos ahora a Google y ponemos site:www.fivexperts.es , veremos que ya no está indexada ninguna página.

¿Alguien nos echa un cablecito?

Contenido solo visible a usuarios registrados

Hola Luis.

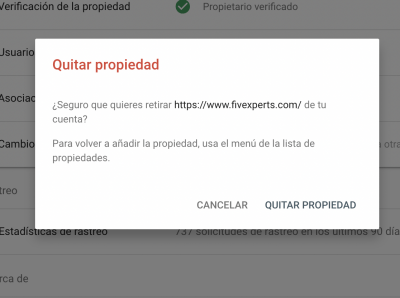

Elimina la propiedad y Empieza desde Cero.

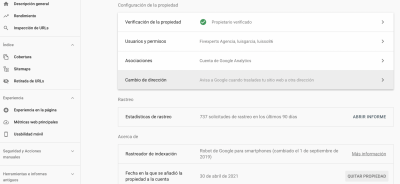

.- Accedes a Search Console:

.- Selecciona Ajustes y pulsa en " Eliminar propiedad "

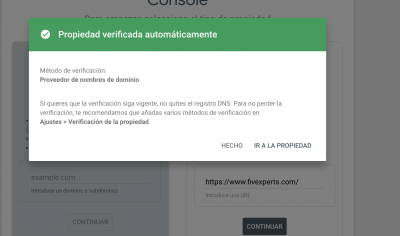

Vuelve a crear al propiedad como te indique en uan respuesta anterior utilizando el archivo.

Si no tienes la propiedad no puede decirte que esta validada.

Un saludo

@pepesoler Hola Pepe,

Así es exactamente como lo hago. (Te adjunto fotos del proceso)

Esperaré hasta el lunes por darle más tiempo.