Optimización de ficheros sensibles

CONTENIDOS

Introducción

Una vez creado el sitio, aunque aún sin contenidos, y antes de proceder con la configuración de WordPress para optimizarlo para el posicionamiento, hay que revisar la configuración de algunos archivos que se han instalado en nuestro WordPress cuando hemos realizado la instalación.

Para ello, existen dos ficheros de texto, robots.txt y .htaccess, que incluyen comandos y parámetros para indicar la configuración del servidor.

El archivo .htaccess se crea automáticamente al instalar WordPress.

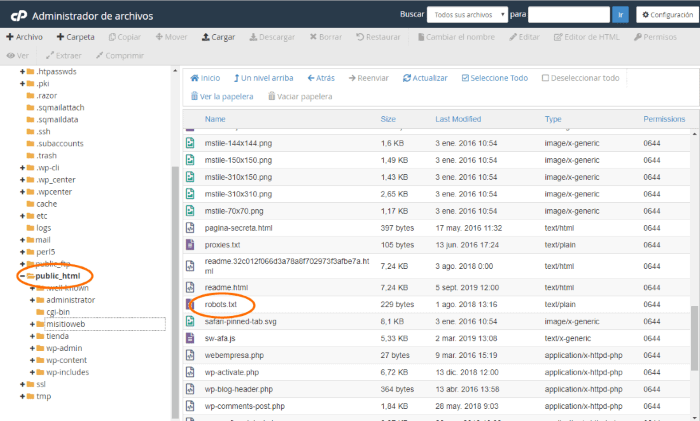

El archivo “robots.txt” NO SE CREA AUTOMÁTICAMENTE al instalar WordPress, por lo que o bien lo gestionas desde el plugin Yoast SEO, o desde tu Administrador de Archivos de cPanel, accedes a la carpeta principal donde tengas la web WordPress y creas un archivo vacío llamado robots.txt y luego añades la información sugerida en el siguiente punto de esta lección.

Normalmente, estos ficheros apenas se modifican durante la vida del sitio web, excepto para situaciones o aspectos muy concretos.

Estos ficheros son críticos para el funcionamiento e indexación de la web y cualquier error en la transcripción de algún comando puede provocar un mal funcionamiento del servidor o incluso su caída.

Por ello, cuando se modifiquen, siempre hay que hacer una copia de seguridad y comprobar que el sitio web funciona correctamente, por si hubiera que restaurarla rápidamente.

Fichero robots.txt: configuración recomendada para SEO

Este fichero incluye instrucciones para los rastreadores de los buscadores; es decir, indicar qué partes del sitio web pueden visitar los bots para analizar, indexar y posicionar, y a qué partes no deben acceder.

La sintaxis puede ser un poco complicada, pero casi todo se centra en allow y disallow, siendo allow para indicar rutas a las que pueden acceder los rastreadores y disallow para indicar que ciertas partes de la web no las rastreen.

Es importante saber que bloquear por robots.txt con un disallow no siempre evita que no indexe el contenido, ya que si nuestro sitio web tiene mucha antigüedad y fuerza, el motor de búsqueda puede indexar nuestro sitio web o sección que bloqueemos, por ello recomiendo que mejor que bloquear por robot.txt, etiquetar esa URL con un No-index.

Sobre todo el robots.txt se suele usar al principio para que Google no indexe una página nueva o para que no vea el contenido que tenemos.

Ejemplo de estructura básica de un archivo robots.txt para WordPress

User-Agent: * Disallow: /cgi-bin/ Disallow: /wp-admin/ Disallow: /archives/ Disallow: /wp-content/plugins/ Disallow: /readme.html Disallow: /refer/ Disallow: /wp-* Disallow: /comments/feed/ User-agent: Googlebot-Image Allow: /wp-content/uploads/ User-agent: Adsbot-Google Allow: / User-agent: Googlebot-Mobile Allow: / Sitemap: http://www.dominio.com/post-sitemap.xml Sitemap: http://www.dominio.com/page-sitemap.xml Sitemap: http://www.dominio.com/hosting-sitemap.xml

Haz clic en el texto o signo + para desplegar el contenido.

Si bien que no es recomendado llamar archivos XML del sitemap desde el archivo robots.txt, para eso tienes muy buenos plugins como Yoast SEO que te permiten llamar de forma independiente a los archivos del sitemap sin tener que ¡mezclar churras con merinas! (offtopic para los que no entiendan el dicho) 🙂

Ejemplo de archivo robots.txt COMPLETO

# robots.txt para un blog WordPress. # Bloquear o permitir acceso a contenido adjunto. # (Si la instalación está en /public_html). User-Agent: * Allow: /wp-content/uploads/ Disallow: /cgi-bin Disallow: /wp-content/plugins/ Disallow: /wp-content/themes/ Disallow: /wp-includes/ Disallow: /wp-admin/ # Desindexar carpetas que empiecen por wp- Disallow: /wp- # Permitir sitemap pero no las búsquedas. Sitemap: http://tu-web/sitemap.xml Disallow: /?s= Disallow: /search # Permitir Feed general para Google Blogsearch. # Impedir que /permalink/feed/ sea indexado pues el feed de comentarios # suele posicionarse antes de los post. # Impedir URLs terminadas en /trackback/ que sirven como Trackback URI # (contenido duplicado). Allow: /feed/$ Disallow: /feed Disallow: /comments/feed Disallow: /*/feed/$ Disallow: /*/feed/rss/$ Disallow: /*/trackback/$ Disallow: /*/*/feed/$ Disallow: /*/*/feed/rss/$ Disallow: /*/*/trackback/$ Disallow: /*/*/*/feed/$ Disallow: /*/*/*/feed/rss/$ Disallow: /*/*/*/trackback/$ # Evita bloqueos de CSS y JS. Allow: /*.js$ Allow: /*.css$ # Lista de bots que deberías permitir. User-agent: Googlebot-Image Allow: /wp-content/uploads/ User-agent: Adsbot-Google Allow: / User-agent: Googlebot-Mobile Allow: / # Lista de bots que generan consultas abusivas aunque siguen # las pautas del archivo robots.txt User-agent: MSIECrawler Disallow: / User-agent: WebCopier Disallow: / User-agent: HTTrack Disallow: / User-agent: Microsoft.URL.Control Disallow: / User-agent: libwww Disallow: / # Slurp (Yahoo!), Noxtrum y el bot de MSN que suelen generar # excesivas consultas. User-agent: noxtrumbot Crawl-delay: 50 User-agent: msnbot Crawl-delay: 30 User-agent: Slurp Crawl-delay: 10

Haz clic en el texto o signo + para desplegar el contenido.

Cuidado con el Crawl-delay si estableces tiempos altos puede que a Google no le guste y lo refleje en el Probador de robots.txt de Google Search Console.

En WordPress, y prestando atención a las nuevas políticas establecidas por Google para el indexado de contenidos, lo mejor es no bloquear el acceso a wp-includes y específicamente a plugins.

Fichero .htaccess: configuración, recomendada para SEO

Este fichero incluye instrucciones de funcionamiento del servidor web, relacionadas con la seguridad, tiempo de expiración de la caché, restricción de acceso, etc.

Mientras que un error en el fichero robots.txt impediría que los buscadores rastreen un sitio web, un error en el .htaccess puede provocar una parada del servidor web, por lo que se debe poner extremado cuidado al modificarlo y comprobar que los comandos y parámetros estén correctamente escritos.

Al modificarlo, es crucial no modificar los comandos creados por la instalación del sitio web, pues pueden ser específicos del proveedor de hosting, y que cualquier nuevo comando se añada al final del fichero de texto, para no interferir con los anteriores.

Estos ficheros aún pueden optimizarse más para el posicionamiento SEO, pero ya requiere disponer de un gran conocimiento técnico tanto de la plataforma web como de los comandos, que se salen del objetivo de este curso.

Este artículo, del fichero robots.txt, y este artículo, del fichero .htaccess, contienen información detallada de todos los comandos de cada uno de ellos.

En el vídeo de esta lección se muestra dónde se encuentran los ficheros de configuración en el servidor web y cómo se pueden editar y modificar desde cPanel.

Archivo .htaccess para WordPress

Este archivo .htaccess comprimido en htaccess.txt.zip deberas descomprimirlo cuando lo descargues y posteriormente editarlo en tu ordenador, con algún editor de texto plano (Notepad++, etc.) y copiar aquellos bloques de directivas que te interese insertar en tu propio archivos .htaccess de tu web.

Ten en cuenta que estos códigos aunque son estándares que deberían funcionar en cualquier web WordPress, es posible que alguno de ellos te genere algún conflicto (o no) si ya implementas lo mismo con algún plugin de seguridad o de SEO.

Haz una copia de seguridad de tu actual archivo .htaccess antes de insertar alguna de las directivas recomendadas en el archivo facilitado.